![Transformer深度解析与NLP应用开发 《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be_1.jpg.avif)

![《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be_1.jpg.avif)

![《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be2.jpg.avif)

![《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be3.jpg.avif)

![《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be4.jpg.avif)

![《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be5.jpg.avif)

![《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be6.jpg.avif)

![《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be7.jpg.avif)

![《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be8.jpg.avif)

![《Transformer深度解析与NLP应用开发》[47M]百度网盘|pdf下载|亲测有效](/ebook66/19474b8a-dcfe-44e6-8ba7-1675960280be9.jpg.avif)

Transformer深度解析与NLP应用开发 pdf下载

内容简介

本篇主要提供Transformer深度解析与NLP应用开发电子书的pdf版本下载,本电子书下载方式为百度网盘方式,点击以上按钮下单完成后即会通过邮件和网页的方式发货,有问题请联系邮箱ebook666@outlook.com

产品特色

编辑推荐

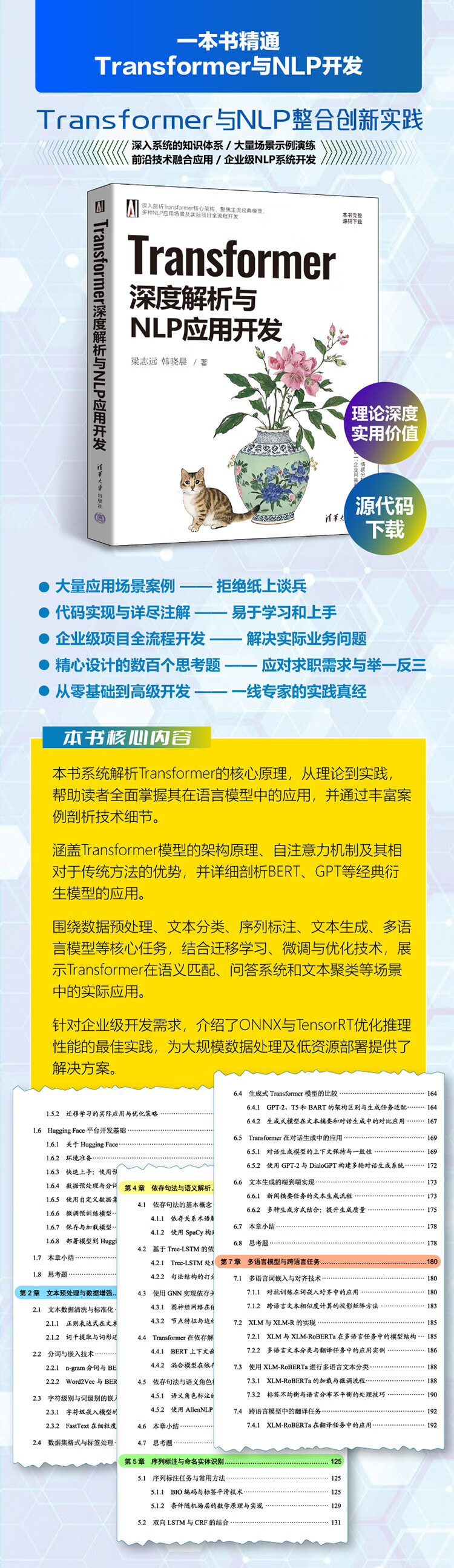

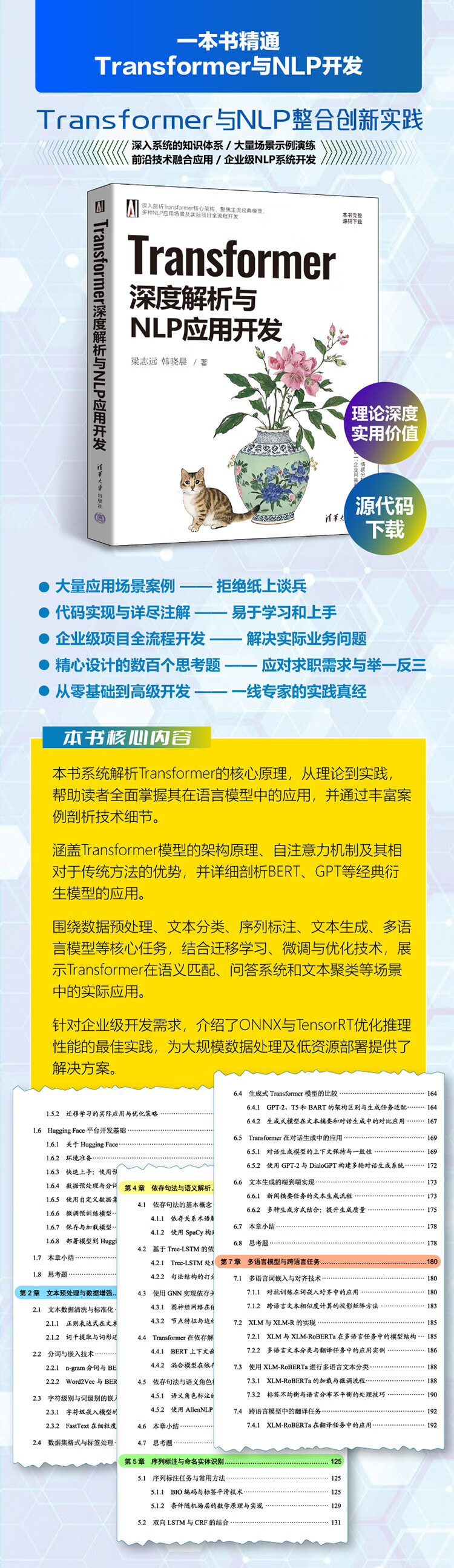

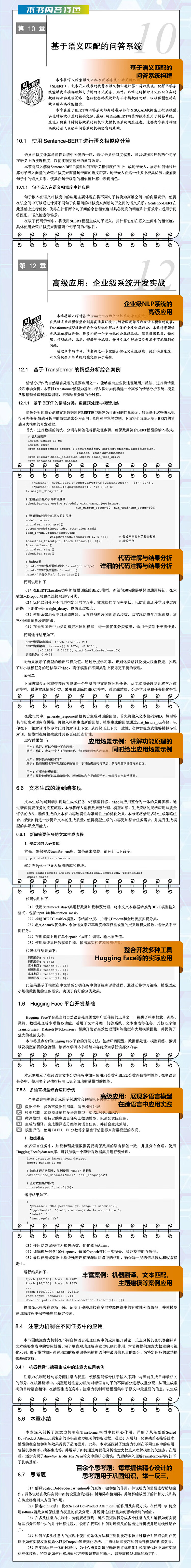

在深度学习领域,Transformer模型以其革新性的架构和卓越的性能,如同一颗璀璨的明星,照亮了自然语言处理(NLP)乃至整个人工智能的发展道路。《Transformer深度解析与NLP应用开发》这本书,无疑是引领读者踏入这一前沿领域的钥匙。

《Transformer深度解析与NLP应用开发》对Transformer架构的核心理论进行了系统而深入的介绍。从架构原理到自注意力机制,详细阐述了其相较于传统方法的显著优势,让读者能够深刻理解这一技术为何能成为深度学习领域的变革者。同时,针对BERT、GPT等经典衍生模型的应用也有详尽的讲解,使读者全面掌握Transformer在语言模型中的广泛应用。

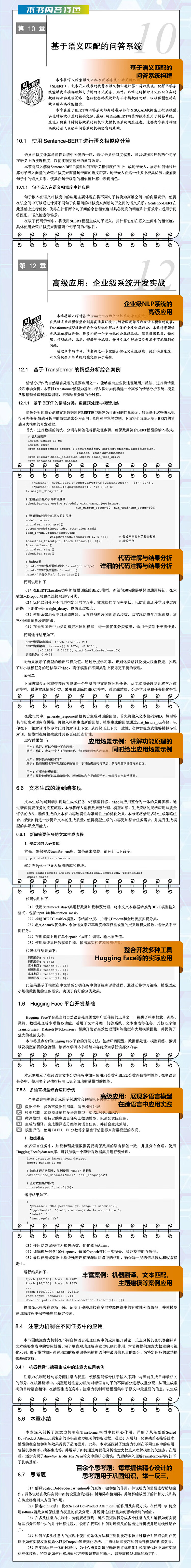

全书内容丰富,分为理论基础、技术实践和高级应用三个部分。在理论基础部分,为读者夯实了知识根基;技术实践部分,围绕数据预处理、文本分类、序列标注、文本生成、多语言模型等核心任务展开,结合迁移学习、微调与优化技术,展示了Transformer在不同场景中的实际运用;高级应用部分则聚焦于语义匹配、问答系统和文本聚类等领域,进一步拓展读者的视野。此外,针对企业级开发需求,特别介绍了ONNX与TensorRT优化推理性能的应用实践,为大规模数据处理及低资源部署提供了切实可行的解决方案。

《Transformer深度解析与NLP应用开发》兼具理论深度与实践应用价值,案例丰富生动。无论是大模型及NLP开发人员、工程师、研究人员,还是数据科学家以及高校师生,都能从中获得宝贵的知识和启示。阅读本书,读者将仿佛置身于一场知识的盛宴,不仅能够深入理解Transformer的核心技术,还能掌握其在NLP应用开发中的实际技巧和方法。相信每一位读者都能从本书中汲取智慧的力量,在Transformer与NLP的应用开发中取得突破,共同推动这一领域的创新发展。

内容简介

《Transformer深度解析与NLP应用开发》系统解析Transformer的核心原理,从理论到实践,帮助读者全面掌握其在语言模型中的应用,并通过丰富案例剖析技术细节。《Transformer深度解析与NLP应用开发》共12章,内容涵盖Transformer模型的架构原理、自注意力机制及其相对于传统方法的优势,并详细剖析BERT、GPT等经典衍生模型的应用。书中围绕数据预处理、文本分类、序列标注、文本生成、多语言模型等核心任务,结合迁移学习、微调与优化技术,展示Transformer在语义匹配、问答系统和文本聚类等场景中的实际应用。针对企业级开发需求,还特别介绍了ONNX与TensorRT优化推理性能的最佳实践,为大规模数据处理及低资源部署提供了解决方案。

《Transformer深度解析与NLP应用开发》兼具理论深度与实际应用价值,内容系统,案例丰富,适合大模型及NLP研发人员、工程师、数据科学研究人员以及高校师生阅读与参考。

作者简介

梁志远,博士,毕业于北京航空航天大学。长期从事人工智能、大语言模型的开发,专注于深度学习、自然语言处理、数据分析与智能决策等领域。主持或参与多项科研项目,涵盖模型训练优化、知识蒸馏、自动推理与多模态学习等方向。致力于推动人工智能技术在工业应用、智能交互与数据驱动中的实践与发展。

韩晓晨,博士,长期从事高性能计算与大模型训练算力优化研究。近十年来,专注于智能计算架构优化及大规模数据处理,深耕控制算法、机器视觉等领域。近年来,重点研究大模型训练加速、算力调度与异构计算优化,致力于提升计算效率与资源利用率,推动大规模人工智能模型的高效部署与应用。

产品特色

编辑推荐

在深度学习领域,Transformer模型以其革新性的架构和卓越的性能,如同一颗璀璨的明星,照亮了自然语言处理(NLP)乃至整个人工智能的发展道路。《Transformer深度解析与NLP应用开发》这本书,无疑是引领读者踏入这一前沿领域的钥匙。

《Transformer深度解析与NLP应用开发》对Transformer架构的核心理论进行了系统而深入的介绍。从架构原理到自注意力机制,详细阐述了其相较于传统方法的显著优势,让读者能够深刻理解这一技术为何能成为深度学习领域的变革者。同时,针对BERT、GPT等经典衍生模型的应用也有详尽的讲解,使读者全面掌握Transformer在语言模型中的广泛应用。

全书内容丰富,分为理论基础、技术实践和高级应用三个部分。在理论基础部分,为读者夯实了知识根基;技术实践部分,围绕数据预处理、文本分类、序列标注、文本生成、多语言模型等核心任务展开,结合迁移学习、微调与优化技术,展示了Transformer在不同场景中的实际运用;高级应用部分则聚焦于语义匹配、问答系统和文本聚类等领域,进一步拓展读者的视野。此外,针对企业级开发需求,特别介绍了ONNX与TensorRT优化推理性能的应用实践,为大规模数据处理及低资源部署提供了切实可行的解决方案。

《Transformer深度解析与NLP应用开发》兼具理论深度与实践应用价值,案例丰富生动。无论是大模型及NLP开发人员、工程师、研究人员,还是数据科学家以及高校师生,都能从中获得宝贵的知识和启示。阅读本书,读者将仿佛置身于一场知识的盛宴,不仅能够深入理解Transformer的核心技术,还能掌握其在NLP应用开发中的实际技巧和方法。相信每一位读者都能从本书中汲取智慧的力量,在Transformer与NLP的应用开发中取得突破,共同推动这一领域的创新发展。

内容简介

《Transformer深度解析与NLP应用开发》系统解析Transformer的核心原理,从理论到实践,帮助读者全面掌握其在语言模型中的应用,并通过丰富案例剖析技术细节。《Transformer深度解析与NLP应用开发》共12章,内容涵盖Transformer模型的架构原理、自注意力机制及其相对于传统方法的优势,并详细剖析BERT、GPT等经典衍生模型的应用。书中围绕数据预处理、文本分类、序列标注、文本生成、多语言模型等核心任务,结合迁移学习、微调与优化技术,展示Transformer在语义匹配、问答系统和文本聚类等场景中的实际应用。针对企业级开发需求,还特别介绍了ONNX与TensorRT优化推理性能的最佳实践,为大规模数据处理及低资源部署提供了解决方案。

《Transformer深度解析与NLP应用开发》兼具理论深度与实际应用价值,内容系统,案例丰富,适合大模型及NLP研发人员、工程师、数据科学研究人员以及高校师生阅读与参考。

作者简介

梁志远,博士,毕业于北京航空航天大学。长期从事人工智能、大语言模型的开发,专注于深度学习、自然语言处理、数据分析与智能决策等领域。主持或参与多项科研项目,涵盖模型训练优化、知识蒸馏、自动推理与多模态学习等方向。致力于推动人工智能技术在工业应用、智能交互与数据驱动中的实践与发展。

韩晓晨,博士,长期从事高性能计算与大模型训练算力优化研究。近十年来,专注于智能计算架构优化及大规模数据处理,深耕控制算法、机器视觉等领域。近年来,重点研究大模型训练加速、算力调度与异构计算优化,致力于提升计算效率与资源利用率,推动大规模人工智能模型的高效部署与应用。

![《指挥与控制原理》[72M]百度网盘|pdf下载|亲测有效](/downpdf2/20240713/3e0f4ed49c76e341.jpg)

![《人工智能ChatGPTAIGCAI书籍深度学习机器学习大模型系列:知识图谱:方法、实践与应用》[73M]百度网盘|pdf下载|亲测有效](/downpdf2/uploads/2024-01-20/d535635c69f2a5eb.jpg)

![《 人工智能教育(第二册)人工智能伴我游》[57M]百度网盘|pdf下载|亲测有效](/365baixing/upload/2025-03-08/29579853-1_w_2.jpg)

![《数据结构与算法分析Java语言描述原书第3版计算机教材程序设计计算机科学丛书》[68M]百度网盘|pdf下载|亲测有效](/jinyihulian/uploads/18e14341a9e10e3f.jpg)