![大模型轻量化:模型压缩与训练加速 《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb3_1.jpg.avif)

![《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb3_1.jpg.avif)

![《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb32.jpg.avif)

![《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb33.jpg.avif)

![《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb34.jpg.avif)

![《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb35.jpg.avif)

![《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb36.jpg.avif)

![《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb37.jpg.avif)

![《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb38.jpg.avif)

![《大模型轻量化:模型压缩与训练加速》[82M]百度网盘|pdf下载|亲测有效](/ebook66/40580cd8-ad32-4ac2-b198-154b9127aeb39.jpg.avif)

大模型轻量化:模型压缩与训练加速 pdf下载

内容简介

本篇主要提供大模型轻量化:模型压缩与训练加速电子书的pdf版本下载,本电子书下载方式为百度网盘方式,点击以上按钮下单完成后即会通过邮件和网页的方式发货,有问题请联系邮箱ebook666@outlook.com

产品特色

编辑推荐

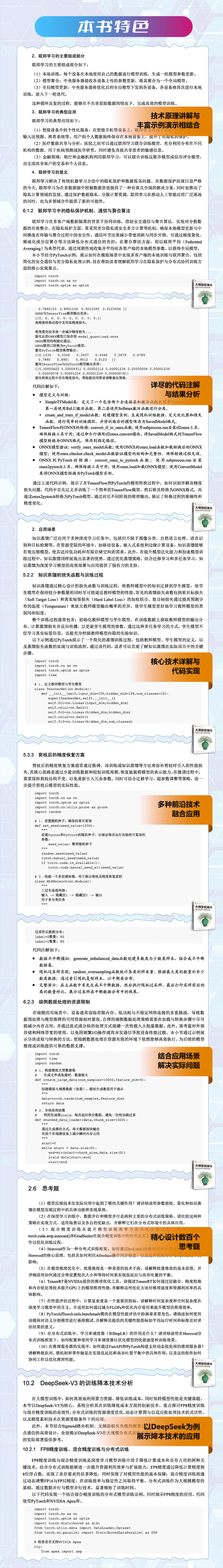

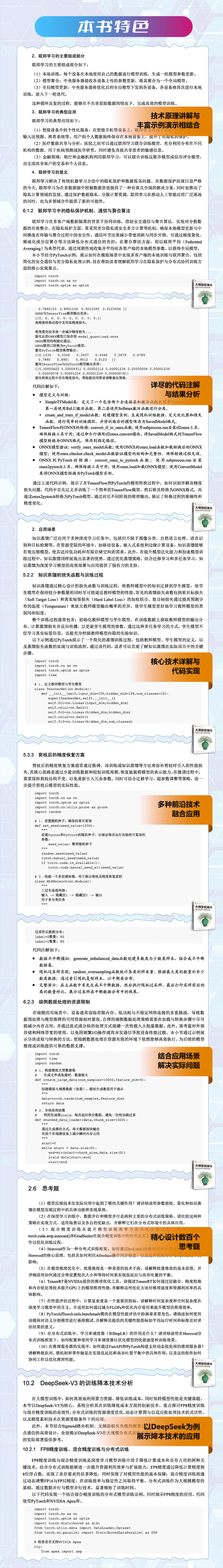

在人工智能领域飞速发展的今天,大模型的应用日益广泛,但随之而来的是模型部署与计算资源的严峻挑战。大模型轻量化技术应运而生,成为解决这一难题的关键。《大模型轻量化:模型压缩与训练加速》一书,犹如一盏明灯,为从事大模型开发与优化的工程师以及研究人员照亮了前行的道路。

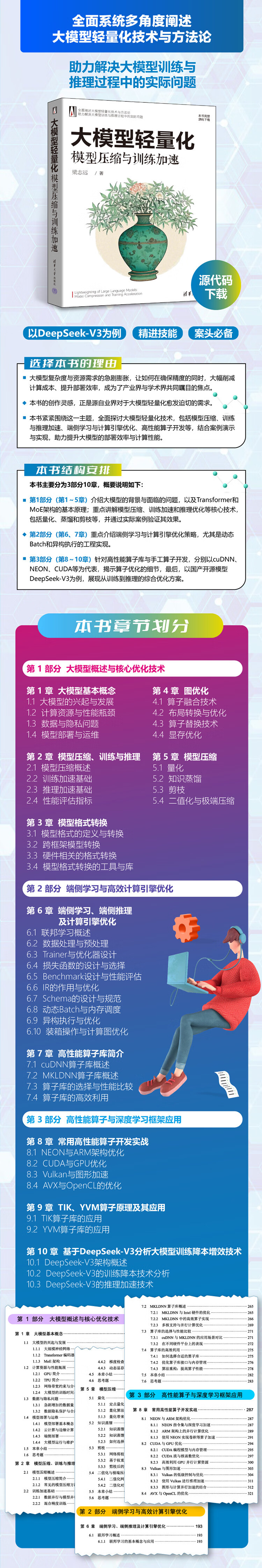

《大模型轻量化:模型压缩与训练加速》围绕大模型轻量化这一核心主题,展开全面而深入的阐述。第一部分介绍大模型的背景及挑战,讲解Transformer和MoE架构的基本原理,让读者对大模型有清晰的认知。聚焦模型压缩、训练加速与推理优化的核心技术,包括量化、蒸馏和剪枝等,并通过实际案例验证其效果,使读者能深刻理解这些技术的价值。

第二部分详述端侧学习与计算引擎优化策略,突出动态 Batch 和异构执行的工程实现。这部分内容为读者揭示了在大模型轻量化过程中,如何通过优化计算资源利用,提高模型的运行效率。

第三部分针对高性能算子库与手工算子开发,以 cuDNN、NEON、CUDA 等为代表,揭示优化细节。并以国产开源模型 DeepSeek-V3 为案例,展示从训练到推理的综合优化方案。不仅为读者提供了具体的实践指导,也展示了国内在大模型轻量化领域的优秀成果。

全书内容丰富实用,结合丰富的代码示例与实践案例,将理论与实践紧密结合。无论是对于从事大模型开发的工程师,还是致力于相关研究的学者,《大模型轻量化:模型压缩与训练加速》都是一本不可多得的佳作。阅读《大模型轻量化:模型压缩与训练加速》,读者将仿佛置身于大模型轻量化的技术殿堂,获得宝贵的知识与经验,助力解决大模型训练与推理中的实际问题,推动人工智能领域的发展。

内容简介

《大模型轻量化:模型压缩与训练加速》围绕大模型轻量化这一主题,系统地阐述大模型轻量化的基本理论与实现方法,旨在提升模型的部署效率和计算性能。全书分为3部分,共10章。第1部分(第1~5章),介绍大模型的背景与面临的问题,以及Transformer和MoE架构的基本原理;重点讲解模型压缩、训练加速和推理优化等核心技术,包括量化、蒸馏和剪枝等,并通过实际案例验证其效果。第2部分(第6、7章),重点介绍端侧学习与计算引擎优化策略,尤其是动态Batch和异构执行的工程实现。第3部分(第8~10章),针对高性能算子库与手工算子开发,分别以cuDNN、NEON、CUDA等为代表,揭示算子优化的细节,最后,以国产开源模型DeepSeek-V3为例,展现从训练到推理的综合优化方案。

《大模型轻量化:模型压缩与训练加速》提供全面实用的轻量化方法论,结合丰富代码示例与实践案例,适合从事大模型开发与优化的工程师,也为研究人员提供深入探讨的素材与视角,助力解决大模型训练与推理中的实际问题。

作者简介

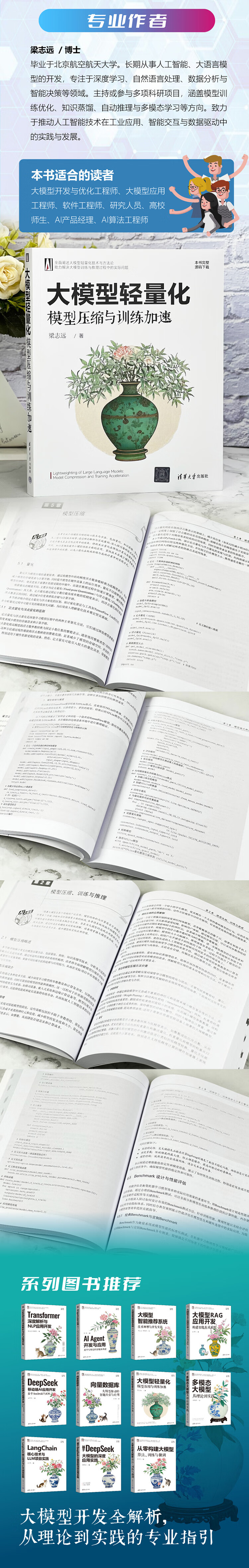

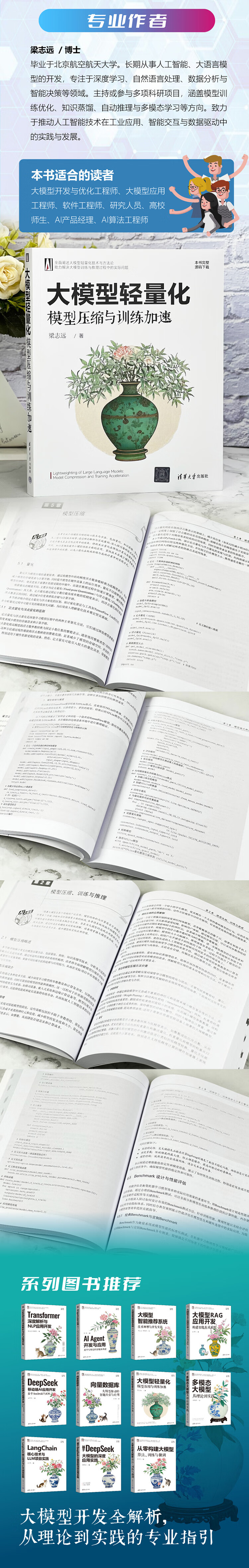

梁志远,博士,毕业于北京航空航天大学。长期从事人工智能、大语言模型的开发,专注于深度学习、自然语言处理、数据分析与智能决策等领域。主持或参与多项科研项目,涵盖模型训练优化、知识蒸馏、自动推理与多模态学习等方向。致力于推动人工智能技术在工业应用、智能交互与数据驱动中的实践与发展。

产品特色

编辑推荐

在人工智能领域飞速发展的今天,大模型的应用日益广泛,但随之而来的是模型部署与计算资源的严峻挑战。大模型轻量化技术应运而生,成为解决这一难题的关键。《大模型轻量化:模型压缩与训练加速》一书,犹如一盏明灯,为从事大模型开发与优化的工程师以及研究人员照亮了前行的道路。

《大模型轻量化:模型压缩与训练加速》围绕大模型轻量化这一核心主题,展开全面而深入的阐述。第一部分介绍大模型的背景及挑战,讲解Transformer和MoE架构的基本原理,让读者对大模型有清晰的认知。聚焦模型压缩、训练加速与推理优化的核心技术,包括量化、蒸馏和剪枝等,并通过实际案例验证其效果,使读者能深刻理解这些技术的价值。

第二部分详述端侧学习与计算引擎优化策略,突出动态 Batch 和异构执行的工程实现。这部分内容为读者揭示了在大模型轻量化过程中,如何通过优化计算资源利用,提高模型的运行效率。

第三部分针对高性能算子库与手工算子开发,以 cuDNN、NEON、CUDA 等为代表,揭示优化细节。并以国产开源模型 DeepSeek-V3 为案例,展示从训练到推理的综合优化方案。不仅为读者提供了具体的实践指导,也展示了国内在大模型轻量化领域的优秀成果。

全书内容丰富实用,结合丰富的代码示例与实践案例,将理论与实践紧密结合。无论是对于从事大模型开发的工程师,还是致力于相关研究的学者,《大模型轻量化:模型压缩与训练加速》都是一本不可多得的佳作。阅读《大模型轻量化:模型压缩与训练加速》,读者将仿佛置身于大模型轻量化的技术殿堂,获得宝贵的知识与经验,助力解决大模型训练与推理中的实际问题,推动人工智能领域的发展。

内容简介

《大模型轻量化:模型压缩与训练加速》围绕大模型轻量化这一主题,系统地阐述大模型轻量化的基本理论与实现方法,旨在提升模型的部署效率和计算性能。全书分为3部分,共10章。第1部分(第1~5章),介绍大模型的背景与面临的问题,以及Transformer和MoE架构的基本原理;重点讲解模型压缩、训练加速和推理优化等核心技术,包括量化、蒸馏和剪枝等,并通过实际案例验证其效果。第2部分(第6、7章),重点介绍端侧学习与计算引擎优化策略,尤其是动态Batch和异构执行的工程实现。第3部分(第8~10章),针对高性能算子库与手工算子开发,分别以cuDNN、NEON、CUDA等为代表,揭示算子优化的细节,最后,以国产开源模型DeepSeek-V3为例,展现从训练到推理的综合优化方案。

《大模型轻量化:模型压缩与训练加速》提供全面实用的轻量化方法论,结合丰富代码示例与实践案例,适合从事大模型开发与优化的工程师,也为研究人员提供深入探讨的素材与视角,助力解决大模型训练与推理中的实际问题。

作者简介

梁志远,博士,毕业于北京航空航天大学。长期从事人工智能、大语言模型的开发,专注于深度学习、自然语言处理、数据分析与智能决策等领域。主持或参与多项科研项目,涵盖模型训练优化、知识蒸馏、自动推理与多模态学习等方向。致力于推动人工智能技术在工业应用、智能交互与数据驱动中的实践与发展。

![《角色委托代理授权:模型与算法计算机与互联网》[75M]百度网盘|pdf下载|亲测有效](/downpdf2/uploads/2024-01-20/c9c0efaf391d90ca.jpg)

![《华为HCIA-Datacom学习指南华为数通认证考试教材华为HCIA应试人员参考书籍网络技术教程》[92M]百度网盘|pdf下载|亲测有效](/downpdf2/uploads/2024-01-20/e5c23dbe2c0426a3.jpg)

![《华为网络技术系列SD-WAN架构与技术盛成》[80M]百度网盘|pdf下载|亲测有效](/downpdf2/uploads/2024-01-20/3d0aa2998f07c605.jpg)

![《响应式:构建企业信息体系》[91M]百度网盘|pdf下载|亲测有效](/downpdf2/uploads/2024-01-20/be6570942712fc59.jpg)